Новини | Вижте всички

Видео записи от OpenFest 2024

Радваме се да обявим официално, че със закъснение, видео-записите от OpenFest 2024 вече са достъпни за гледане: В нашия видео-архив; В YouTube.

виж цялата новинаПриятно посрещане на празниците и новата 2025та година

Екипът на OpenFest иска да ви пожелае приятно прекарване на празниците и да обяви, че OpenFest 2025 ще се проведе на 17-18 Октомври 2025, пак във форум „Джон Атанасов“. Ще се радваме да се видим пак догодина 🙂

виж цялата новина#OpenFest2024 ще бяга заедно с #5kmrun.bg

🏃♀️ Събота, 16ти Ноември, Старт: 10:00ч. 🗺️ Южния парк – N 42°40’19.3 , E 023°18’27.9 Спортът е за всеки, без значение от възраст, произход или физическо състояние. От екипа на OpenFest 2024 сме много радостни да ви разкажем за общите инициативи с партньорите ни от 5kmrun.bg . Каним всички да се присъединят към общността […]

виж цялата новинаOpenFest си партнира с LPI

Linux Professional Institute (LPI) е глобалният стандарт за сертифициране и организацията за кариерна подкрепа на професионалистите, работещи с отворен код. С над 250 000 притежатели на сертификати, това е първият и най-голям в света орган за сертифициране в областта на Linux и отворения код, който е неутрален по отношение на доставчика. LPI има сертифицирани професионалисти […]

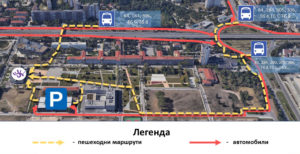

виж цялата новинаКак се стига до мястото на събитието и други полезни съвети за OpenFest 2024

Започваме този гайд как да оцелеем и да се забавляваме на OpenFest с най-важния въпрос: Как се стига до мястото на събитието – София Тех Парк? С градски транспорт С тролейбус Тролеи 3 и 5 до спирка „София Тех Парк“ Тролеи 4 и 11 до спирка „Площад на авиацията“ С автобус Автобуси 1, 3, 5, […]

виж цялата новинаДонесете си бутилка за вода на OpenFest2024

Донесете си чаши или бутилки за многократна употреба на OpenFest. Ще имаме пречистена на момента, питейна вода от диспенсъри за филтрирана вода благодарение на Culligan. Нека заедно покажем, че можем да бъдем отговорни и да се грижим за природатата. Всеки малък жест има значение.

виж цялата новина